Redis-3-高级篇-分布式缓存

单机的 Redis 存在四大问题:

- 数据丢失问题(解决方案:实现 Redis 数据持久化)

- 并发能力问题(解决方案:搭建主从集群,实现读写分离)

- 存储能力问题(解决方案:搭建分片集群,利用插槽机制实现动态扩容)

- 故障恢复问题(解决方案:利用 Redis 哨兵,实现健康检测和自动恢复)

Redis 持久化

RDB 持久化

RDB 全称 Redis Database Backup file(Redis数据备份文件),也被叫做 Redis 数据快照。简单来说就是把内存中的所有数据都记录到磁盘中。当 Redis 实例故障重启后,从磁盘读取快照文件,恢复数据。快照文件称为 RDB 文件,默认是保存在当前运行目录。

执行时机

RDB 持久化在四种情况下会执行:

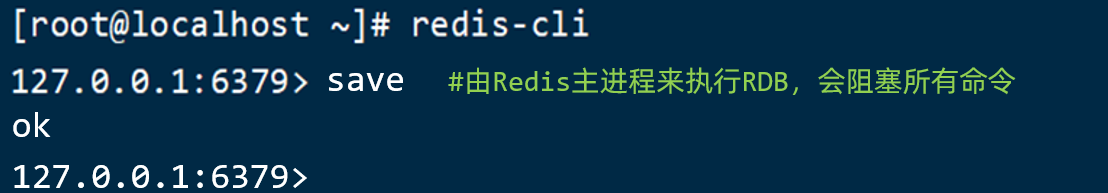

执行 save 命令:save 命令会导致主进程执行 RDB,这个过程中其它所有命令都会被阻塞。只有在数据迁移时可能用到。

执行下面的命令,可以立即执行一次 RDB

执行 bgsave 命令:这个命令执行后会开启独立进程完成 RDB,主进程可以持续处理用户请求,不受影响。

下面的命令可以异步执行 RDB:

停机时:Redis停机时会执行一次 save 命令,实现 RDB 持久化。

触发 RDB 条件:

Redis 内部有触发 RDB 的机制,可以在 redis.conf 文件中找到,格式如下:

1 | # 900秒内,如果至少有1个key被修改,则执行bgsave , 如果是save "" 则表示禁用RDB |

RDB的其它配置也可以在 redis.conf 文件中设置:

1 | # 是否压缩 ,建议不开启,压缩也会消耗cpu,磁盘的话不值钱 |

RDB原理

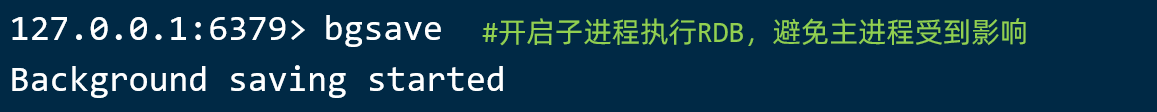

bgsave 开始时会 fork 主进程得到子进程,子进程共享主进程的内存数据。完成 fork 后读取内存数据并写入 RDB 文件。

fork 采用的是 copy-on-write 技术:

- 当主进程执行读操作时,访问共享内存;

- 当主进程执行写操作时,则会拷贝一份数据,执行写操作

小结

RDB 方式 bgsave 的基本流程

- fork 主进程得到一个子进程,共享内存空间

- 子进程读取内存数据并写入新的 RDB 文件

- 用新 RDB 文件替换旧的 RDB 文件

RDB 执时机,save 60 1000 代表含义?

- 默认是服务停止时

- 代表60秒内至少执行1000次修改则触发RDB

RDB的缺点

- RDB执行间隔时间长,两次RDB之间写入数据有丢失的风险

- fork子进程、压缩、写出RDB文件都比较耗时

AOF 持久化

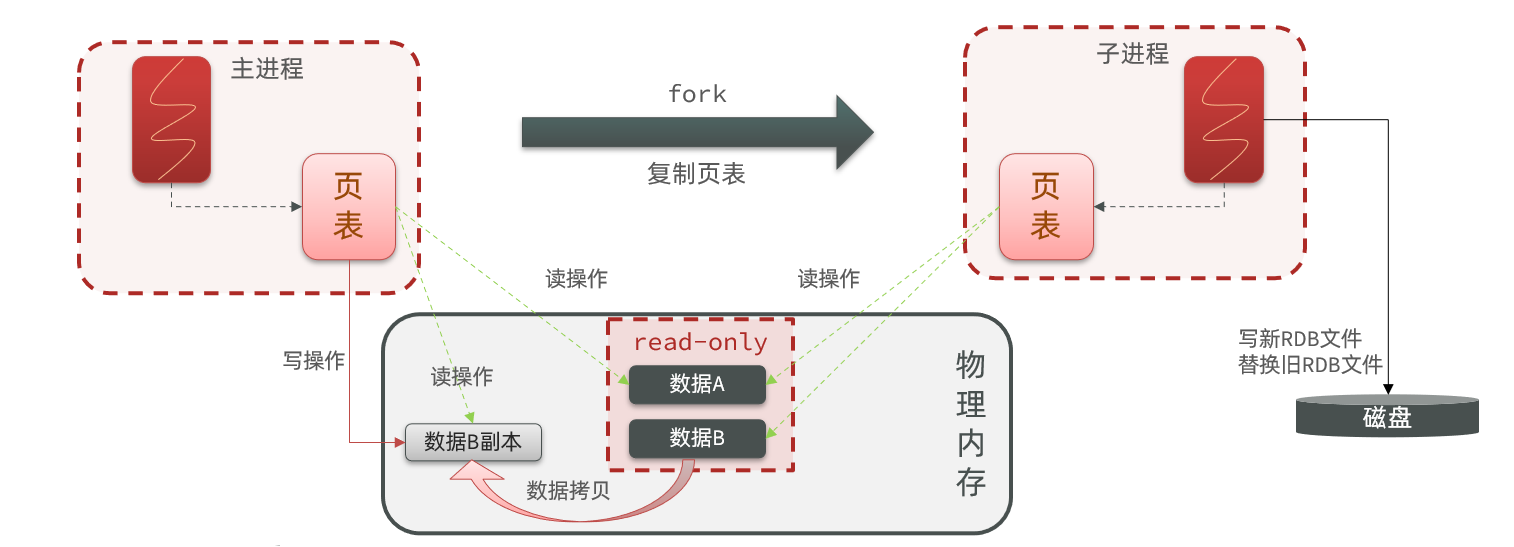

AOF 原理

AOF 全称为 Append Only File(追加文件)。Redis 处理的每一个写命令都会记录在 AOF 文件,可以看做是命令日志文件。

AOF 配置

AOF 默认是关闭的,需要修改 redis.conf 配置文件来开启AOF:

1 | # 是否开启AOF功能,默认是no |

AOF 的命令记录的频率也可以通过 redis.conf 文件来配:

1 | # 表示每执行一次写命令,立即记录到AOF文件 |

三种策略对比:

| 配置项 | 刷盘时机 | 优点 | 缺点 |

|---|---|---|---|

Always |

同步刷盘 | 可靠性高,几乎不丢数据 | 性能影响大 |

everysec |

每秒刷盘 | 性能适中 | 最多丢失1秒数据 |

no |

操作系统控制 | 性能最好 | 可靠性较差,可能丢失大量数据 |

AOF 文件重写

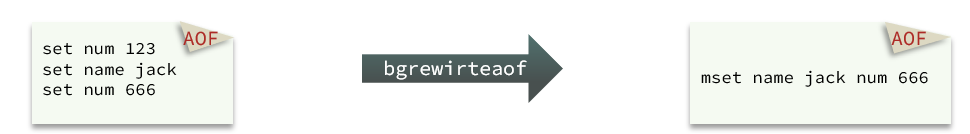

因为是记录命令,AOF 文件会比 RDB 文件大的多。而且 AOF 会记录对同一个 key 的多次写操作,但只有最后一次写操作才有意义。通过执行 bgrewriteaof 命令,可以让 AOF 文件执行重写功能,用最少的命令达到相同效果。

如图,AOF 原本有三个命令,但是 set num 123 和 set num 666 都是对 num 的操作,第二次会覆盖第一次的值,因此第一个命令记录下来没有意义。

所以重写命令后,AOF 文件内容就是:mset name jack num 666

Redis 也会在触发阈值时自动去重写 AOF 文件。阈值也可以在 redis.conf 中配置:

1 | # AOF文件比上次文件 增长超过多少百分比则触发重写 |

RDB 与 AOF 对比

RDB 和 AOF 各有自己的优缺点,如果对数据安全性要求较高,在实际开发中往往会 结合 两者来使用。

| RDB | AOF | |

|---|---|---|

| 持久化方式 | 定时对整个内存做快照 | 记录每一次执行的命令 |

| 数据完整性 | 不完整,两次备份之间会丢失 | 相对完整,取决于刷盘策略 |

| 文件大小 | 会有压缩,文件体积小 | 记录命令,文件体积很大 |

| 岩机恢复速度 | 很快 | 慢 |

| 数据恢复优先级 | 低,因为数据完整性不如AOF | 高,因为数据完整性更高 |

| 系统资源占用 | 高,大量CPU和内存消耗 | 低,主要是磁盘IO资源但AOF重写时会占用大量CPU和内存资源 |

| 使用场景 | 可以容忍数分钟的数据丢失,追求更快的启动速度 | 对数据安全性要求较高常见 |

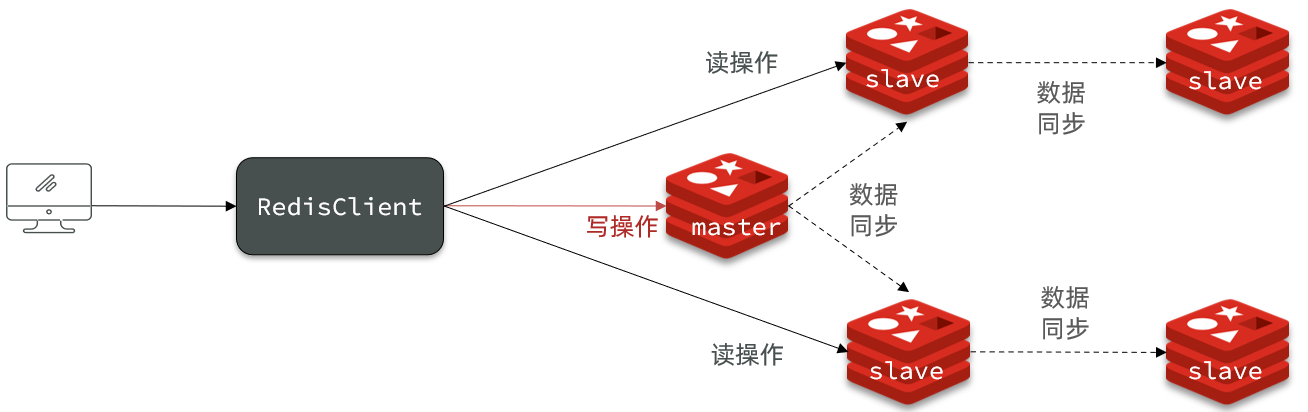

Redis 主从

搭建主从架构

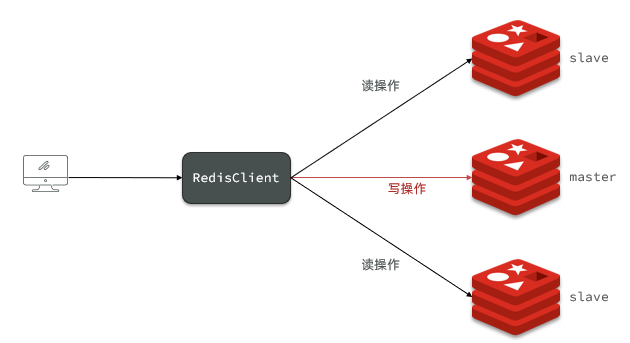

单节点 Redis 的并发能力是有上限的,要进一步提高 Redis 的并发能力,就需要搭建主从集群,实现读写分离。

主从数据同步原理

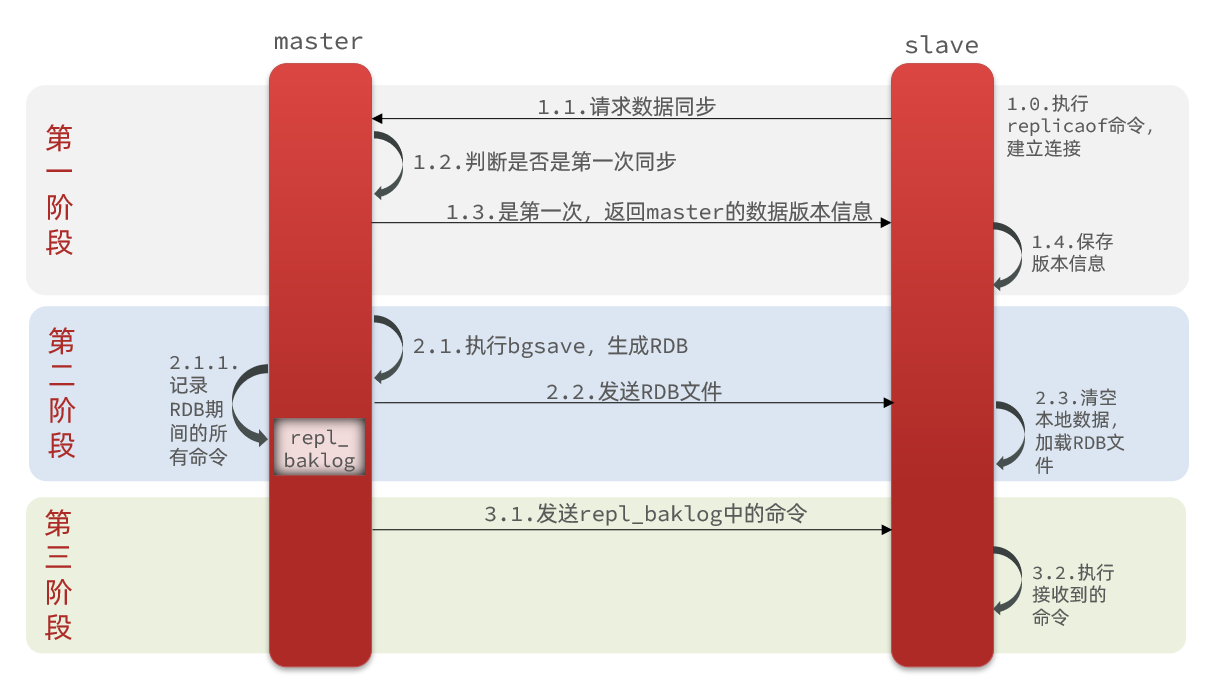

全量同步

主从第一次建立连接时,会执行 全量同步,将 master 节点的所有数据都拷贝给 slave 节点

master 如何得知 salve 是第一次来连接

- Replication Id:简称 replid,是数据集的标记,id 一致则说明是同一数据集。每一个 master 都有唯一的 replid, slave 则会继承 master 节点的 replid

- offset:偏移量,随着记录在 repl_baklog 中的数据增多而逐渐增大。slave 完成同步时也会记录当前同步的 offset。如果 slave 的 offset 小于 master 的 offset,说明 slave 数据落后于 master,需要更新。

因此 slave 做数据同步,必须向 master 声明自己的 replication id 和 offset,master 才可以判断到底需要同步哪些数据。

因为 slave 原本也是一个 master,有自己的 replid 和 offset,当第一次变成 slave,与 master 建立连接时,发送的 replid 和 offset 是自己的 replid 和 offset。master 判断发现 slave 发送来的 replid 与自己的不一致,说明这是一个全新的 slave,就知道要做全量同步。master 会将自己的 replid 和 offset 都发送给这个 slave,slave 保存这些信息。以后 slave 的 replid 就与 master 一致。

因此,master 判断一个节点是否是第一次同步的依据,就是看 replid 是否一致。

全量同步流程描述

第一阶段:

slave 与 master 建立连接,请求进行增量同步

master 节点判断请求 replid 是否一致,此时两者 replid 发现不一致,说明两者属于第一次同步,拒绝来自 slave 的请求增量同步

- 将 master 的 replid 和 offset 保存至 slave 版本信息中

第二阶段:

master 生成 RDB 文件,发送 RDB 至 slave,同时将 RDB 期间的命令记录至 repl_baklog

slave 清空本地数据,加载 master 的 RDB

第三阶段:

master 将 repl_baklog 中的命令发送给 slave

slave 执行接收到的命令,保持与 master 之间的同步

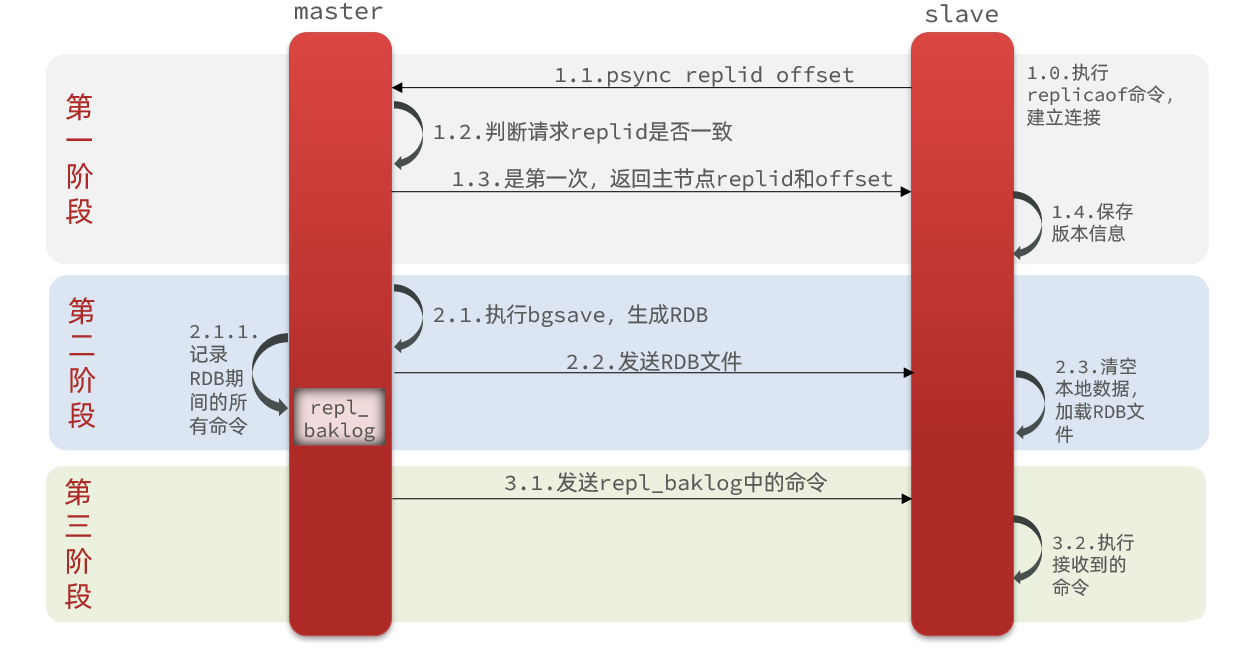

增量同步

全量同步需要先做 RDB,然后将 RDB 文件通过网络传输给 slave,成本太高。因此除了第一次做全量同步,其它大多数时候 slave 与 master 都是做增量同步,即更新 slave 与 master 存在差异的部分数据。

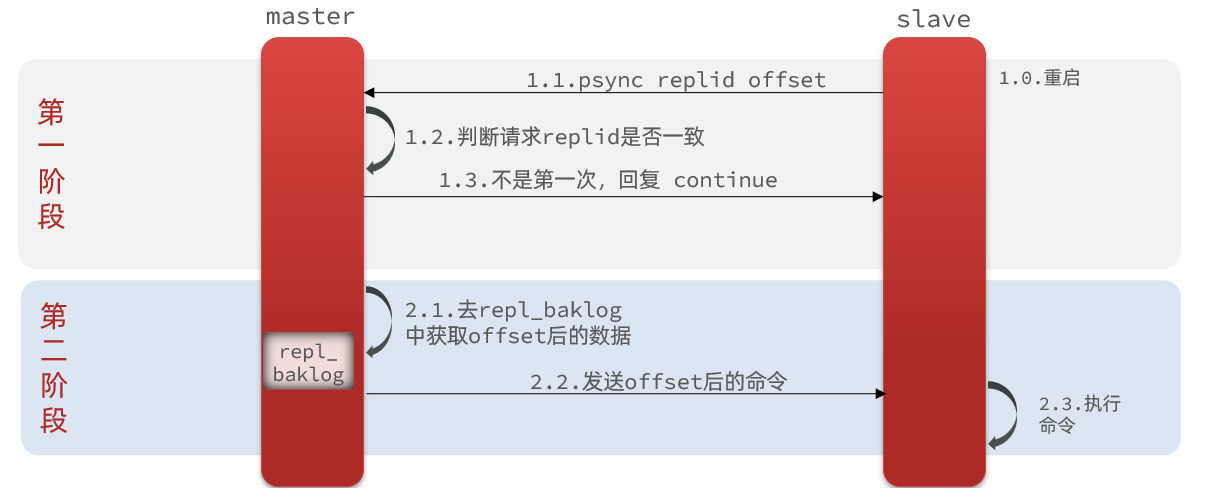

增量同步流程描述

第一阶段:

- slave 请求进行增量同步

- master 判断请求 replid 是否一致,此时不是第一次进行同步,master 给出 slave 回复

第二阶段:

- master 从 repl_baklog 中获取 offset 后的数据

- master 发送命令给 slave 执行,更新 slave 与 master 存在差异的部分数据

repl_backlog 原理

master 如何得知 slave 与自己的数据差异

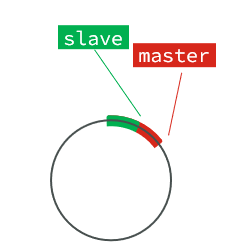

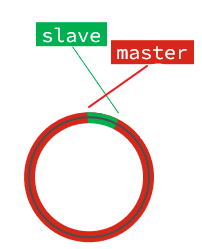

此时考虑全量同步时的 repl_baklog 文件。它是一个固定大小的数组,只不过数组是环形,也就是说 角标到达数组末尾后,会再次从 0 开始读写,这样数组头部的数据就会被覆盖。repl_baklog 中会记录 Redis 处理过的命令日志及 offset,包括 master 当前的 offset,和 slave 已经拷贝到的 offset,slave 与 master 的 offset之间的差异,就是 salve 需要增量拷贝的数据

随着不断有数据写入,master 的 offset 逐渐变大,slave 也不断的拷贝,追赶 master 的 offset:

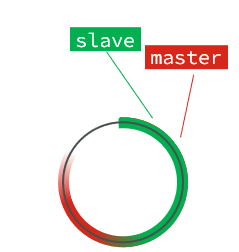

直到数组被填满:

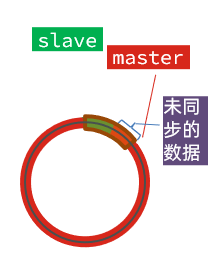

此时,如果有新的数据写入,就会覆盖数组中的旧数据。不过,旧的数据只要是绿色的,说明是已经被同步到 slave 的数据,即便被覆盖了也没什么影响。因为未同步的仅仅是红色部分。

但是,如果 slave 出现网络阻塞,导致 master 的 offset 远远超过了 slave 的 offset:

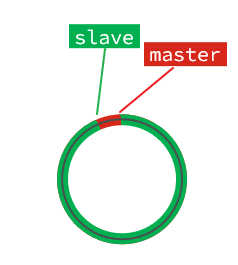

如果 master 继续写入新数据,其 offset 就会覆盖旧的数据,直到将 slave 现在的 offset 也覆盖:

棕色框中的红色部分,就是尚未同步,但是却已经被覆盖的数据。此时如果 slave 恢复,需要同步,却发现自己的 offset 都没有了,无法完成增量同步。只能做全量同步。

注意

repl_baklog 大小有上限,写满后会覆盖最早的数据。如果 slave 断开时间过久,导致尚未备份的数据被覆盖,则无法基于 log 做增量同步,只能再次全量同步。

主从同步优化

主从同步可以保证主从数据的一致性,以下优化方式

- 在 master 中配置 repl-diskless-sync yes 启用无磁盘复制,避免全量同步时的磁盘 IO

- Redis 单节点上的内存占用不要太大,减少 RDB 导致的过多磁盘 IO

- 适当提高 repl_baklog 的大小,发现 slave 宕机时尽快实现故障恢复,尽可能避免全量同步

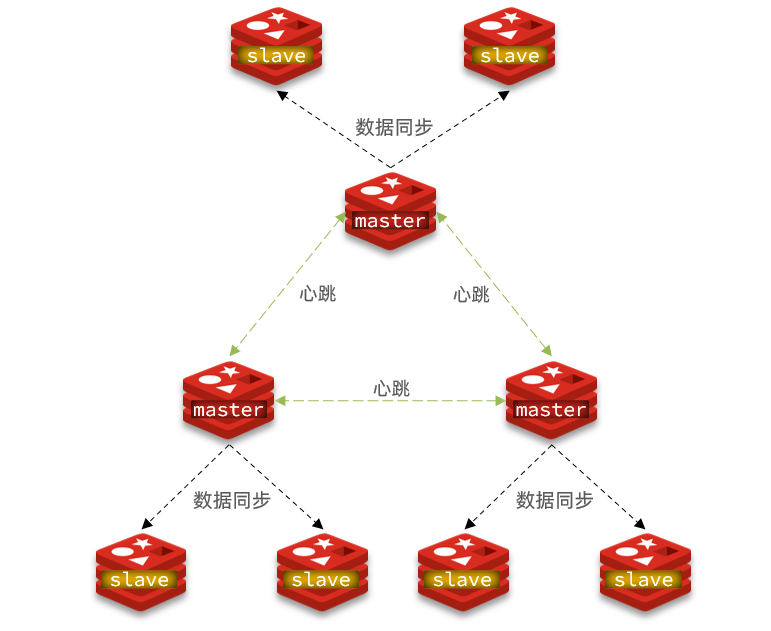

- 限制一个 master 上的 slave 节点数量,如果实在是太多 slave,则可以采用主-从-从链式结构,减少 master 压力

主从从架构图:

小结

全量同步和增量同步区别

- 全量同步:master 将完整内存数据生成 RDB,发送 RDB 到 slave。后续命令则记录在 repl_baklog,逐个发送给 slave。

- 增量同步:slave 提交自己的 offset 到 master,master 获取 repl_baklog 中从 offset 之后的命令给 slave

全量同步执行时机

- slave 节点第一次连接 master 节点时

- slave 节点断开时间太久,repl_baklog 中的 offset 已经被覆盖时

增量同步执行时机

- slave 节点断开又恢复,并且在 repl_baklog 中能找到 offset 时

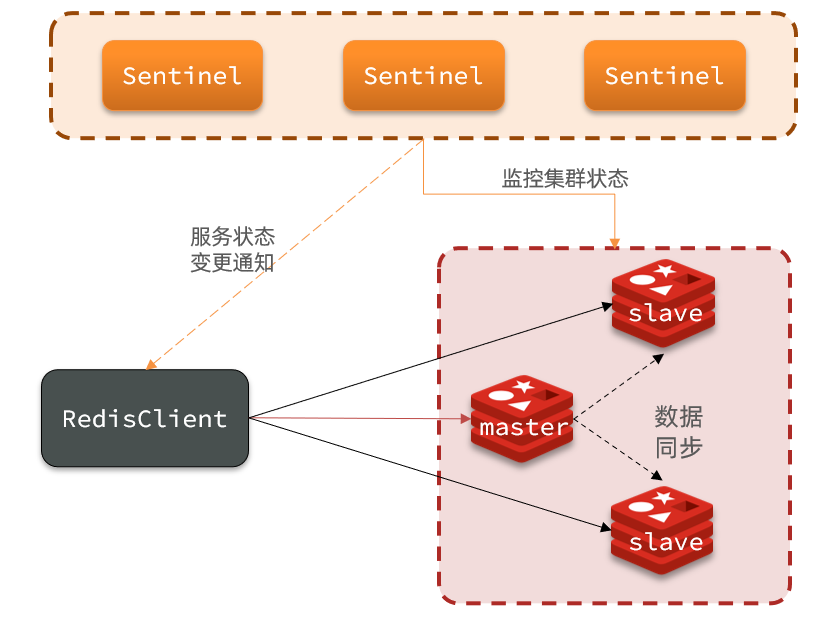

Redis 哨兵

Redis 提供了哨兵(Sentinel)机制来实现主从集群的自动故障恢复。

哨兵原理

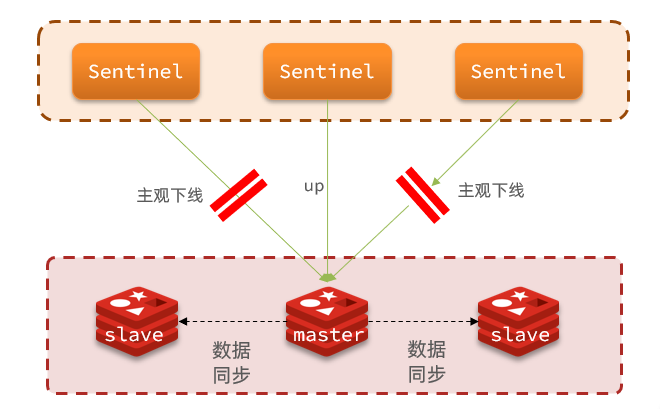

集群结构和作用

哨兵的作用:

- 监控:Sentinel 会不断检查您的 master 和 slave 是否按预期工作

- 自动故障恢复:如果 master 故障,Sentinel 会将一个 slave 提升为 master。当故障实例恢复后也以新的 master 为主

- 通知:Sentinel 充当 Redis 客户端的服务发现来源,当集群发生故障转移时,会将最新信息推送给 Redis 的客户端

集群监控原理

Sentinel 基于心跳机制监测服务状态,每隔 1 秒向集群的每个实例发送 ping 命令:

主观下线:如果某 sentinel 节点发现某实例未在规定时间响应,则认为该实例 主观下线。

客观下线:若超过指定数量(quorum)的 sentinel 都认为该实例主观下线,则该实例客观下线。quorum 值最好超过 Sentinel 实例数量的一半。

集群故障恢复原理

一旦发现 master 故障,sentinel 需要在 salve 中选择一个作为新的 master,选择依据是这样的:

- 首先会判断 slave 节点与 master 节点断开时间长短,如果超过指定值(down-after-milliseconds * 10)则会排除该 slave 节点

- 然后判断 slave 节点的 slave-priority 值,越小优先级越高,如果是 0 则永不参与选举

- 如果 slave-prority 一样,则判断 slave 节点的 offset 值,越大说明数据越新,优先级越高

- 最后是判断 slave 节点的运行id大小,越小优先级越高。

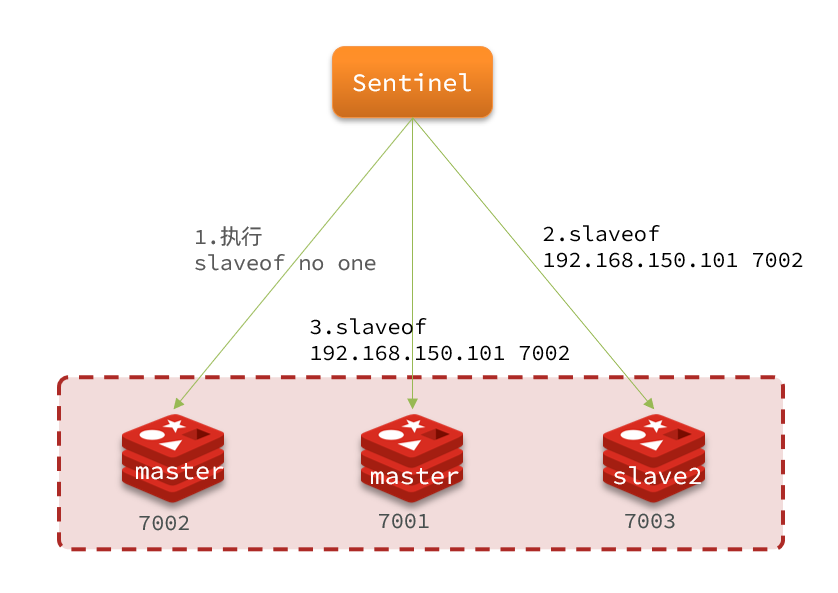

当选出一个新的 master 后,该如何实现切换呢?

流程如下:

- sentinel 给备选的 slave1 节点发送 slaveof no one 命令,让该节点成为 master

- sentinel 给所有其它 slave 发送 slaveof 192.168.150.101 7002 命令,让这些 slave 成为新 master 的从节点,开始从新的 master 上同步数据。

- 最后,sentinel 将故障节点标记为 slave,当故障节点恢复后会自动成为新的 master 的 slave 节点

小结

Sentinel 的作用

- 监控

- 故障转移

- 通知

Sentinel 如何判断一个 redis 实例是否健康

- 每隔 1 秒发送一次 ping 命令,如果超过一定时间没有相向则认为是主观下线

- 如果大多数 sentinel 都认为实例主观下线,则判定服务下线

故障转移步骤

- 首先选定一个 slave 作为新的 master,执行 slaveof no one

- 然后让所有节点都执行 slaveof 新master

- 修改故障节点配置,添加 slaveof 新master

RedisTemplate

在 Sentinel 集群监管下的 Redis 主从集群,其节点会因为自动故障转移而发生变化,Redis 的客户端必须感知这种变化,及时更新连接信息。Spring 的 RedisTemplate 底层利用 Lettuce 实现了节点的感知和自动切换。

在项目的 pom 文件中引入依赖:

1 | <dependency> |

在配置文件application.yml中指定redis的sentinel相关信息:

1 | spring: |

配置读写分离

在项目的启动类中,添加一个新的 bean:

1 |

|

ReadFrom 配置的就是读写策略,包括四种:

MASTER:从主节点读取MASTER_PREFERRED:优先从 master 节点读取,master 不可用才读取 replicaREPLICA:从 slave(replica)节点读取REPLICA _PREFERRED:优先从 slave(replica)节点读取,所有的 slave 都不可用才读取 master

Redis 分片集群

搭建分片集群

主从和哨兵可以解决高可用、高并发读的问题。但是依然有两个问题没有解决:

海量数据存储问题

高并发写的问题

使用分片集群可以解决上述问题

分片集群特征:

集群中有多个 master,每个 master 保存不同数据

每个 master 都可以有多个 slave 节点

master 之间通过 ping 监测彼此健康状态

客户端请求可以访问集群任意节点,最终都会被转发到正确节点

散列插槽

插槽原理

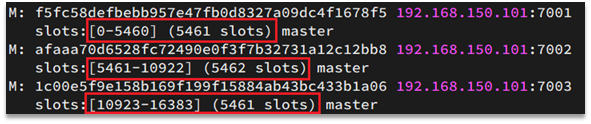

Redis 会把每一个 master 节点映射到 0~16383 共 16384 个插槽(hash slot)上,查看集群信息时就能看到:

数据 key 不是与节点绑定,而是与插槽绑定。redis 会根据 key 的有效部分计算插槽值,分两种情况:

- key 中包含

{},且{}中至少包含 1 个字符,{}中的部分是有效部分 - key 中不包含

{},整个 key 都是有效部分

例如:key 是 num,那么就根据 num 计算,如果是 {itcast}num,则根据 itcast 计算。计算方式是利用 CRC16 算法得到一个 hash 值,然后对 16384 取余,得到的结果就是 slot 值。

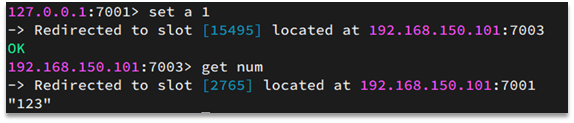

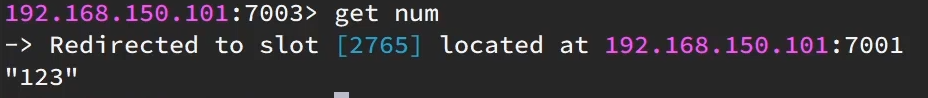

如图,在 7001 这个节点执行 set a 1 时,对 a 做 hash 运算,对 16384 取余,得到的结果是 15495,因此要存储到 103 节点。

到了 7003 后,执行 get num 时,对 num 做 hash 运算,对 16384 取余,得到的结果是 2765,因此需要切换到 7001 节点

小结

Redis 如何判断某个 key 应该在哪个实例

- 将 16384 个插槽分配到不同的实例

- 根据 key 的有效部分计算哈希值,对 16384 取余

- 余数作为插槽,寻找插槽所在实例即可

如何将同一类数据固定的保存在同一个 Redis 实例

- 这一类数据使用相同的有效部分,例如 key 都以 {typeId} 为前缀

集群伸缩

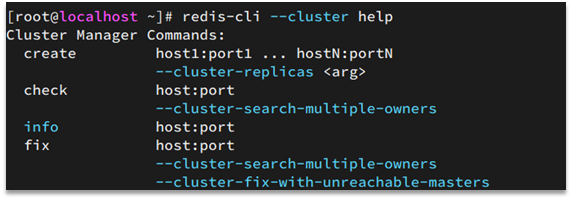

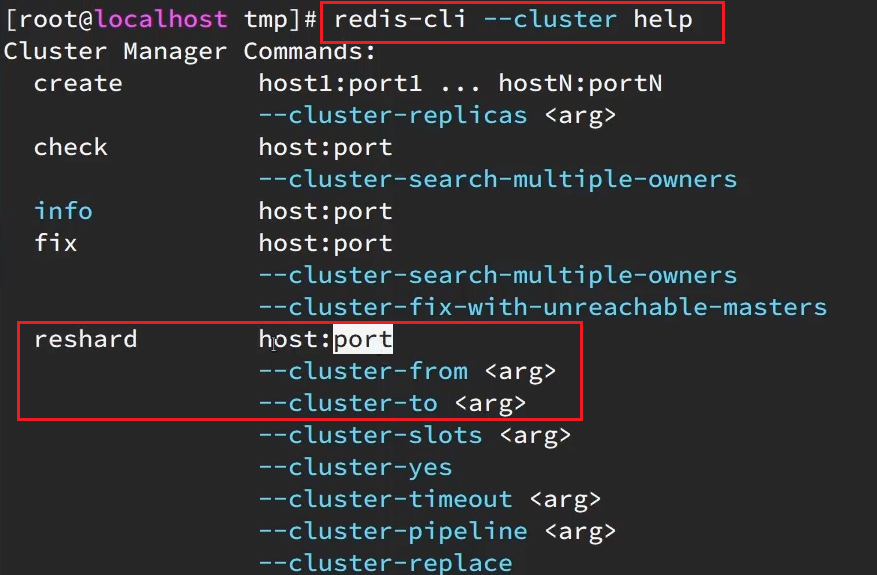

redis-cli --cluster 提供了很多操作集群的命令,可以通过下面方式查看:

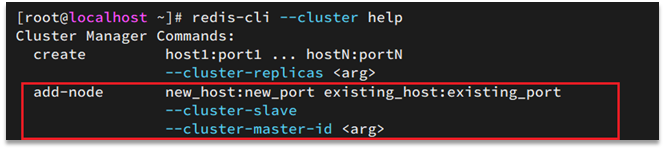

比如,添加节点的命令:

需求分析

需求:向集群中添加一个新的 master 节点,并向其中存储 num = 10

- 启动一个新的 redis 实例,端口为 7004

- 添加 7004 到之前的集群,并作为一个 master 节点

- 给 7004 节点分配插槽,使得 num 这个 key 可以存储到 7004 实例

两个新的功能:

- 添加一个节点到集群中

- 将部分插槽分配到新插槽

创建新的 redis 实例

创建一个文件夹:

1 | mkdir 7004 |

拷贝配置文件:

1 | cp redis.conf /7004 |

修改配置文件:

1 | sed /s/6379/7004/g 7004/redis.conf |

启动

1 | redis-server 7004/redis.conf |

添加新节点到 redis

添加节点的语法如下:

执行命令:

1 | redis-cli --cluster add-node 192.168.150.101:7004 192.168.150.101:7001 |

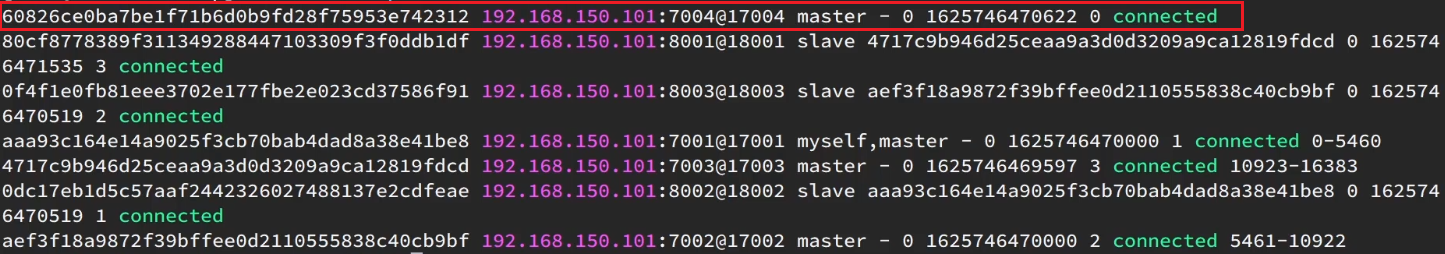

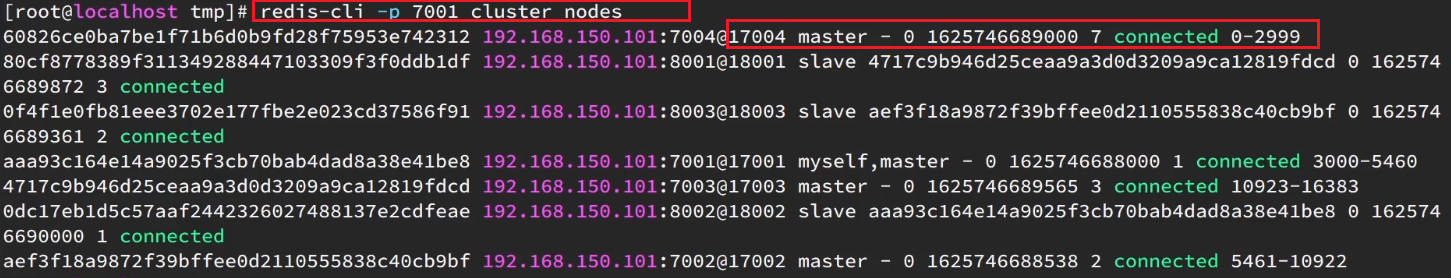

如图,7004 加入了集群,并且默认是一个 master 节点:

但是,可以看到 7004 节点的插槽数量为 0,因此没有任何数据可以存储到 7004 上

转移插槽

要将 num 存储到 7004 节点,因此需要先看看 num 的插槽是多少:

如上图所示,num 的插槽为 2765。

可以将 0~3000 的插槽从 7001 转移到 7004,命令格式如下:

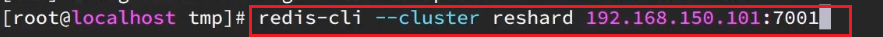

具体命令如下:

建立连接:

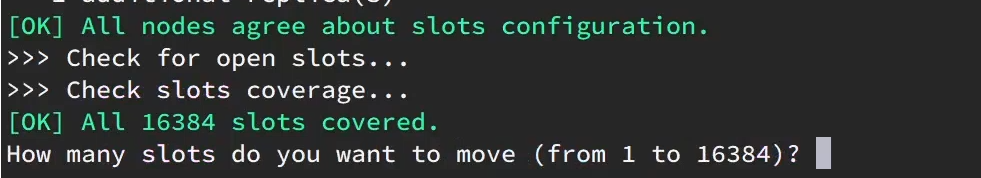

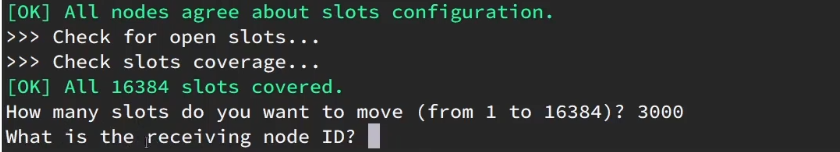

得到下面的反馈:

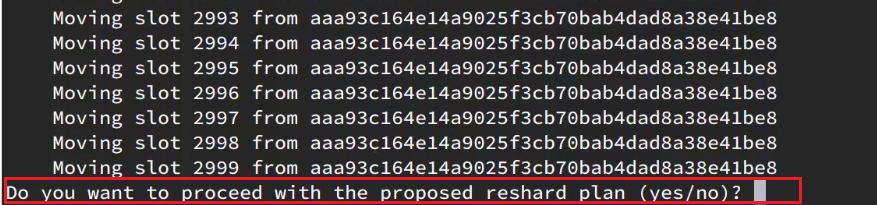

询问要移动多少个插槽,计划是 3000 个:

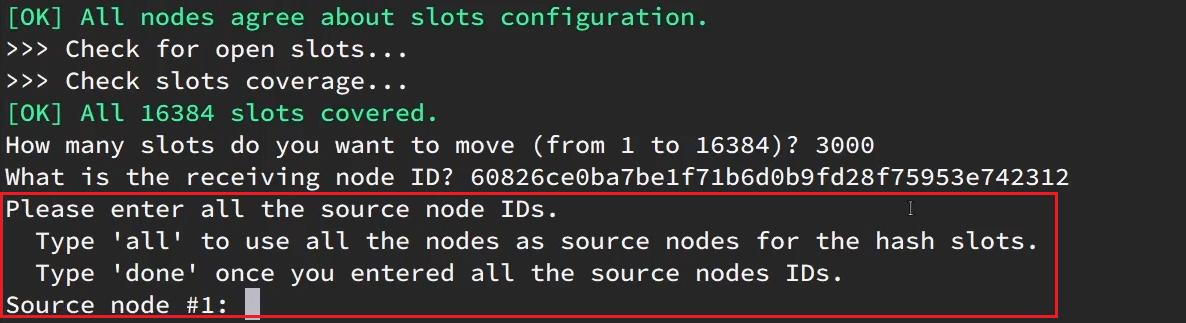

新的问题来了:

哪个 node 来接收这些插槽??

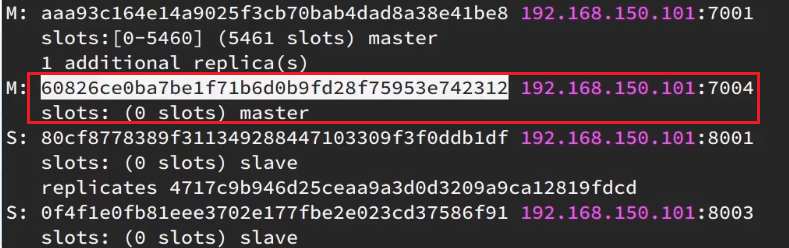

显然是 7004,那么 7004 节点的 id 是多少呢?

复制这个 id,然后拷贝到刚才的控制台后:

这里询问,你的插槽是从哪里移动过来的?

- all:代表全部,也就是三个节点各转移一部分

- 具体的 id:目标节点的 id

- done:没有了

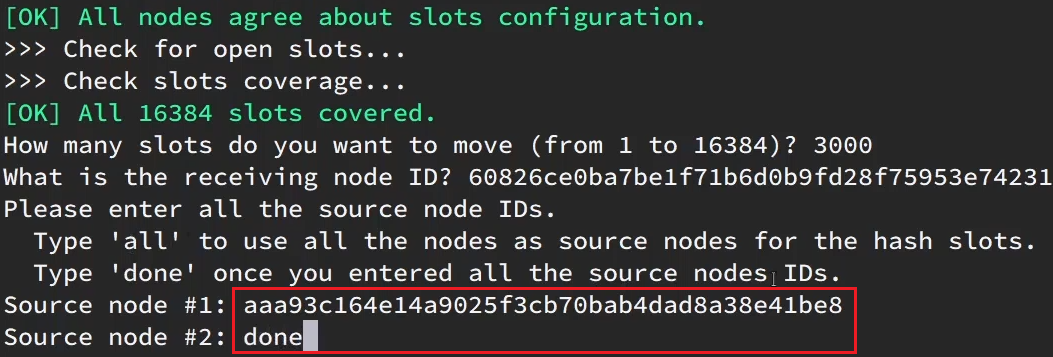

这里我们要从 7001 获取,因此填写 7001 的 id:

填完后,点击 done,这样插槽转移就准备好了:

确认要转移吗?输入 yes:

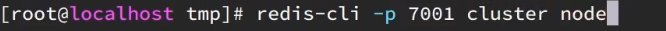

然后,通过命令查看结果:

可以看到:

目的达成。

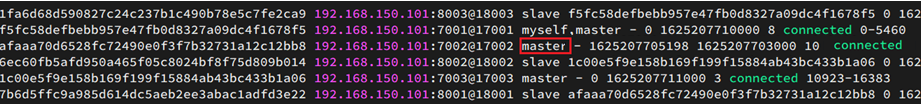

故障转移

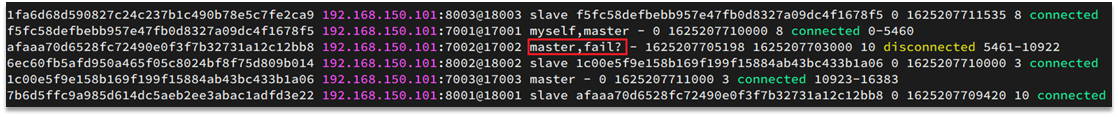

集群初识状态是这样的:

其中 7001、7002、7003 都是 master,我们计划让 7002 宕机。

自动故障转移

当集群中有一个 master 宕机会发生什么呢?

直接停止一个 redis 实例,例如 7002:

1 | redis-cli -p 7002 shutdown |

1)首先是该实例与其它实例失去连接

2)然后是疑似宕机:

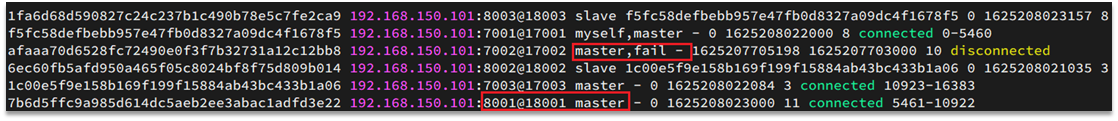

3)最后是确定下线,自动提升一个 slave 为新的 master:

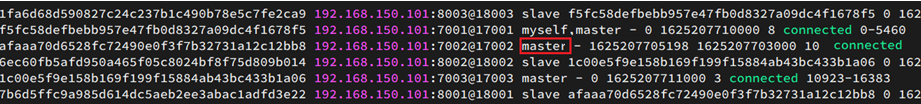

4)当 7002 再次启动,就会变为一个 slave 节点了:

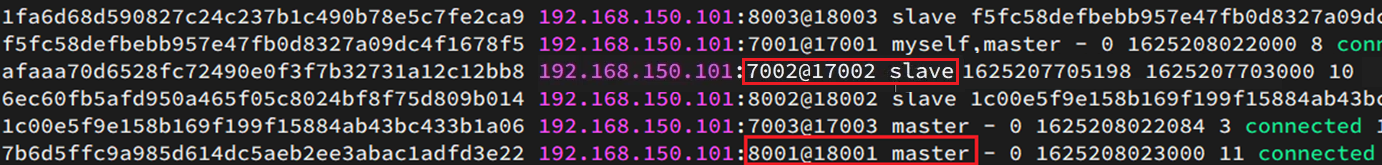

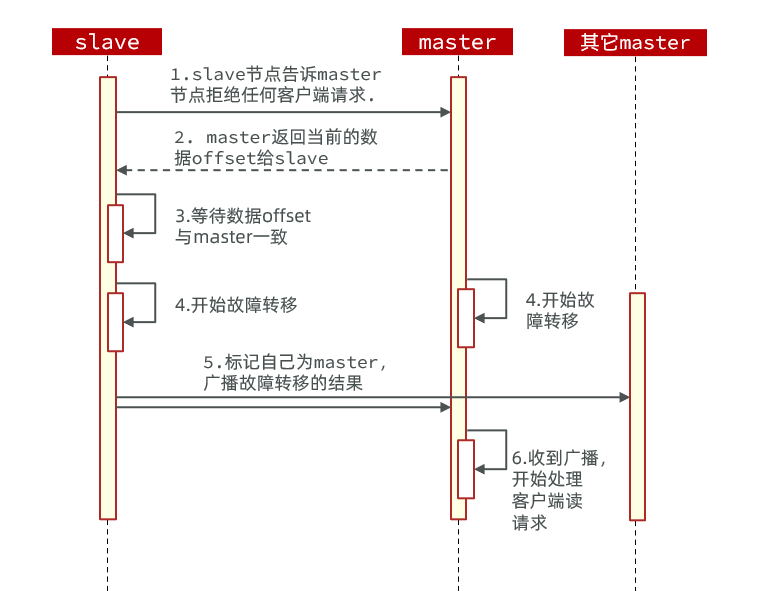

手动故障转移

利用 cluster failover 命令可以手动让集群中的某个 master 宕机,切换到执行 cluster failover 命令的这个 slave 节点,实现无感知的数据迁移。其流程如下:

failover 命令可以指定三种模式:

- 缺省:默认的流程,如图 1~6 歩

- force:省略了对 offset 的一致性校验

- takeover:直接执行第5歩,忽略数据一致性、忽略 master 状态和其它 master 的意见

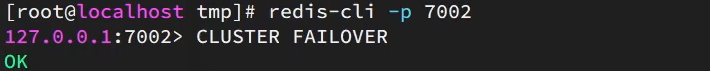

案例需求:在 7002 这个 slave 节点执行手动故障转移,重新夺回 master 地位

1)利用 redis-cli 连接 7002 这个节点

2)执行 cluster failover 命令

RedisTemplate 访问分片集群

RedisTemplate 底层同样基于 lettuce 实现了分片集群的支持,而使用的步骤与哨兵模式基本一致:

1)引入 redis 的 starter 依赖

2)配置分片集群地址

3)配置读写分离

与哨兵模式相比,其中只有分片集群的配置方式略有差异,如下:

1 | spring: |